Термодинамика, статистическая физика, информационная энтропия

Лекция 2.

Термодинамика, статистическая физика, информационная энтропия

1. Сведения из термодинамики и статистической физики. Функция распределения. Теорема Лиувилля. Микроканоническое распределение. Первое начало термодинамики. Адиабатические процессы. Энтропия. Статистический вес. Формула Больцмана. Второе начало термодинамики. Обратимые и необратимые процессы.

2. Информационная энтропия Шеннона. Биты, наты, триты и проч. Связь энтропии и информации.

Эта часть относится к лекции 1. Ее лучше рассматривать в разделе V (“Концепция “перепутывания” (entanglement) квантовых состояний”).

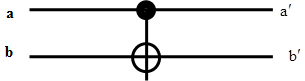

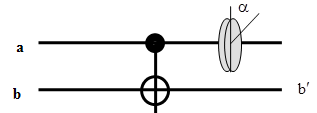

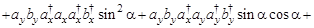

ЛЭ CNOT изображается в виде:

Сохраняем значение (ку)бита а, в то время как (ку)бит b меняется по закону XOR:

бит b (мишень = target) меняет свое состояние тогда и только тогда, когда состояние контрольного (control) бита a соответствует 1; при этом, состояние контрольного бита не меняется.

Логическая операция XOR (CNOT) иллюстрирует почему классические данные могут быть клонированы, а квантовые - нет. Заметим, что в общем случае под квантовыми данными мы будем понимать суперпозиции вида

, (1)

, (1)

где  и

и  - комплексные числа или амплитуды состояний, причем,

- комплексные числа или амплитуды состояний, причем,  .

.

Согласно таблице истинности, если XOR применить к булевым данным, в которых второй бит находится в состоянии “0” (b), а первый -в состоянии “Х” (a), то первый бит не изменяется, а второй становится его копией:

UXOR(X, 0) = (X, X), где Х = “0” или “1”.

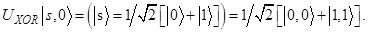

В квантовом случае, в качестве данных, обозначенных символом “Х”, нужно рассматривать суперпозицию (1):

.

.

Физически, данные можно закодировать, например, в поляризационном базисе |V> = 1, |H> = 0 (H,V)= (0,1):

и

и

Видно, что действительно имеет место копирование состояния. Теорема о запрете клонирования утверждает, что невозможно копирование произвольного квантового состояния. В рассмотренном примере копирование произошло, поскольку операция производилась в собственном базисе (|0>, |1>), т.е. в частном случае квантового состояния.

Казалось бы, что операцию XOR можно использовать и для копирования суперпозиций двух булевых состояний, таких как |450> ? |V> + |H>:

Но это не так! Унитарность квантовой эволюции требует, чтобы суперпозиция входных состояний преобразовывалась в соответствующую суперпозицию выходных состояний:

или

или

(2)

(2)

Это т.н. перепутанное состояние (Ф+), в котором каждый из двух выходных кубитов не имеет определенного значения (в данном случае - поляризации). Этот пример показывает, что логические операции, выполняемые над квантовыми объектами происходят по другим правилам, нежели в классических вычислительных процессах.

Возникает следующий вопрос: Вроде бы состояние в выходной моде а опять-таки можно представить в виде суперпозиции  , как и состояние в моде b. Как показать, что это не так, т.е., что вообще нет смысла говорить о состояниях моды (бита) a и моды (бита) b?

, как и состояние в моде b. Как показать, что это не так, т.е., что вообще нет смысла говорить о состояниях моды (бита) a и моды (бита) b?

Воспользуемся поляризационной аналогией, когда

(3).

(3).

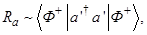

Есть два пути. Путь 1 - длинный, но более последовательный. Надо посчитать средние значения параметров Стокса для обеих выходных мод. Средние берутся по волновой функции (2). Если все  , кроме

, кроме  окажутся равными нулю - то это состояние неполяризованное, т.е. смешанное и суперпозиция (3) смысла не имеет. Работаем в представлении Гейзенберга, когда преобразуются операторы, а волновая функция - нет.

окажутся равными нулю - то это состояние неполяризованное, т.е. смешанное и суперпозиция (3) смысла не имеет. Работаем в представлении Гейзенберга, когда преобразуются операторы, а волновая функция - нет.

Итак, находим  в моде a.

в моде a.

- общая интенсивность пучка а,

- общая интенсивность пучка а,

- доля вертикальной поляризации,

- доля вертикальной поляризации,

- доля +450-ой поляризации,

- доля +450-ой поляризации,

- доля право-циркулярной поляризации.

- доля право-циркулярной поляризации.

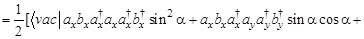

Волновая функция, по которой производится усреднение, берется в виде (2):

,

,

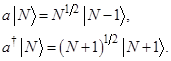

где операторы рождения и уничтожения в модах a и b действуют по правилам:

{Вычисления  сделать в разделе V (см.тетрадь). Там же рассчитать и вероятность регистрации совпадений или коррелятор вида

сделать в разделе V (см.тетрадь). Там же рассчитать и вероятность регистрации совпадений или коррелятор вида  }

}

Путь II - более наглядный, но менее “честный”!

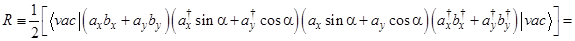

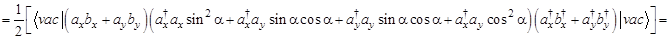

Найдем зависимость интенсивности света в моде a от угла поворота поляроида, помещенного в эту моду. Это стандартный квантово-оптический способ проверки состояния (2) - интенсивность не должна зависеть от поворота. В то же время, аналогичная зависимость числа совпадений имеет вид

. Впервые такие зависимости были получены Э.Фраем (1976) и А.Аспеком (1985) и часто интерпретируется как доказательство нелокальности квантовой механики.

. Впервые такие зависимости были получены Э.Фраем (1976) и А.Аспеком (1985) и часто интерпретируется как доказательство нелокальности квантовой механики.

Итак, экспериментальная ситуация изображена на рисунке:

По определению

где  - оператор уничтожения в моде а. Известно, что преобразование операторов двух ортогонально поляризованных мод x и y при прохождении света через поляроид, ориентированный под углом

- оператор уничтожения в моде а. Известно, что преобразование операторов двух ортогонально поляризованных мод x и y при прохождении света через поляроид, ориентированный под углом  имеет вид:

имеет вид:

.

.

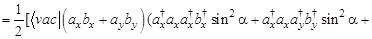

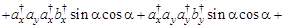

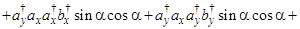

Тогда

(только первое, четвертое, пятое и восьмое слагаемые отличны от нуля) =

(только первое, четвертое, пятое и восьмое слагаемые отличны от нуля) =

(только первое и восьмое слагаемые отличны от нуля) =

(только первое и восьмое слагаемые отличны от нуля) =  - не зависит от угла ?!

- не зависит от угла ?!

Физически это происходит потому, что волновая функция (2) не факторизуется и нет смысла говорить о состояниях в модах а и b по отдельности. Таким образом, нельзя утверждать, что мода а находится в суперпозиционном состоянии (3)!

Замечание. Проделанные вычисления (Путь II) вовсе не доказывают, что состояние в моде а неполяризованное. Например, при наличии в этой моде циркулярно-поляризованного света, результат получился бы таким же. Строгое доказательство - например, через параметры Стокса (в разделе V).

Заметим, что действуя таки же образом, можно доказать, что состояние в моде а до элемента CNOT - поляризованное.

Здесь усреднение нужно проводить по волновой функции исходного состояния (3). Результат получается таким:

т.е. максимум отсчетов достигается при

т.е. максимум отсчетов достигается при  = 450.

= 450.

Информация и энтропия.

Не вводя пока “операционального” термина “информация” будем рассуждать, пользуясь “бытовым” языком. Т.е. информация - это некое знание об объекте.

За то, что понятия информация и энтропия тесно связаны, говорит следующий пример. Рассмотрим идеальный газ, находящийся в термодинамическом равновесии. Газ состоит из огромного количества молекул, которые двигаются в объеме V. Параметрами состояния являются давление, температура. Число состояний такой системы огромно. Энтропия газа при ТД равновесии максимальна и как следует из формулы Больцмана, определяется числом микросостояний системы. При этом мы ничего не знаем о том, какое конкретно состояние имеет система в данный момент времени у нас нет - информация минимальна. Допустим, что каким-то образом нам удалось с помощью очень быстрого прибора “подсмотреть состояние системы в данный момент времени. Значит мы получили о ней какую-то информацию. Можно даже представить, что мы сфотографировали не только координаты молекул, но и их скорости (например, сделав несколько фотографий одну за другой). При этом в каждые моменты времени, когда нам доступна информация о состоянии системы, энтропия стремится к нулю, т.к. система находится лишь в каком-то одном определенном состоянии из всего огромного их многообразия и это состояние сильно неравновесное. Этот пример показывает, что действительно информация и энтропия как-то связаны, причем уже вырисовывается характер связи: чем больше информация, тем меньше энтропия.

Сведения из термодинамики и статистической физики.

Физические величины, характеризующие макроскопические состояния тел (много молекул), называют термодинамическими (в том числе, энергия, объем). Существуют, однако, и величины, появляющиеся как результат действия чисто статистических закономерностей и имеющие смысл в применении только к макроскопическим системам. Такова, например, энтропия и температура.

Классическая статистика

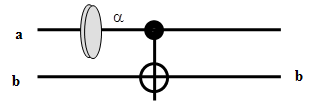

*Теорема Лиувилля. Функция распределения постоянна вдоль фазовых траекторий подсистемы (речь идет о квазизамкнутых подсистемах, поэтому теорема справедлива только для не очень больших промежутков времени, в течение которых подсистема ведет себя как замкнутая).

Здесь -  - функция распределения или плотность вероятности. Она вводится через вероятность w обнаружить подсистему в элементе фазового пространства

- функция распределения или плотность вероятности. Она вводится через вероятность w обнаружить подсистему в элементе фазового пространства  в данный момент времени: dw =

в данный момент времени: dw =  (p1,...,ps, q1,...,qs)dpdq, причем

(p1,...,ps, q1,...,qs)dpdq, причем

. (4)

. (4)

Нахождение статистического распределения  для любой подсистемы и является основной задачей статистики. Если статистическое распределение известно, то можно вычислить вероятности различных значений любых физических величин, зависящих от состояний этой подсистемы (т.е. от значений координат и импульсов):

для любой подсистемы и является основной задачей статистики. Если статистическое распределение известно, то можно вычислить вероятности различных значений любых физических величин, зависящих от состояний этой подсистемы (т.е. от значений координат и импульсов):

.

.

*Микроканоническое распределение.

Распределение  для совокупности двух подсистем (они полагаются замкнутыми, т.е. слабовзаимодействующими) равно

для совокупности двух подсистем (они полагаются замкнутыми, т.е. слабовзаимодействующими) равно . Поэтому

. Поэтому  - логарифм функции распределения - величина аддитивная. Из теоремы Лиувилля следует, что функция распределения должна выражаться через такие комбинации переменных p и q, которые при движении подсистемы, как замкнутой, должны оставаться постоянными (такие величины называются интегралами движения). Значит сама функция распределения является интегралом движения. Более того, ее логарифм - тоже интеграл движения, причем аддитивный. Всего в механике существует семь интегралов движения - энергия, три компоненты импульса и три компоненты момента импульса -(для подсистемы а: Еа (p, q), Pа (p, q), Ма (p, q)). Единственная аддитивная комбинация этих величин есть

- логарифм функции распределения - величина аддитивная. Из теоремы Лиувилля следует, что функция распределения должна выражаться через такие комбинации переменных p и q, которые при движении подсистемы, как замкнутой, должны оставаться постоянными (такие величины называются интегралами движения). Значит сама функция распределения является интегралом движения. Более того, ее логарифм - тоже интеграл движения, причем аддитивный. Всего в механике существует семь интегралов движения - энергия, три компоненты импульса и три компоненты момента импульса -(для подсистемы а: Еа (p, q), Pа (p, q), Ма (p, q)). Единственная аддитивная комбинация этих величин есть

, (*)

, (*)

причем коэффициенты  (их семь штук)- должны оставаться одинаковыми для всех подсистем данной замкнутой системы, а

(их семь штук)- должны оставаться одинаковыми для всех подсистем данной замкнутой системы, а  выбирается из условий нормировки (4).

выбирается из условий нормировки (4).

Чтобы выполнялось условие нормировки (4), необходимо, чтобы функция  (p,q) обращалась в точках Е0, Р0, М0 в бесконечность. Более точная формулировка дает выражение

(p,q) обращалась в точках Е0, Р0, М0 в бесконечность. Более точная формулировка дает выражение

. - микроканоническое распределение.

. - микроканоническое распределение.

Наличие  - функций обеспечивает обращение

- функций обеспечивает обращение  в нуль для всех точек фазового пространства, в которых хотя бы одна из величин Е, Р, М не равна своему заданному (среднему) значению Е0, Р0, М0.

в нуль для всех точек фазового пространства, в которых хотя бы одна из величин Е, Р, М не равна своему заданному (среднему) значению Е0, Р0, М0.

От шести интегралов P и М можно избавится, заключив систему в твердый ящик, в котором она покоится.

Тогда

.

.

Физическая энтропия

Опять используем понятие идеального газа.

Пусть одноатомный идеальный газ с плотностью n и температурой Т занимает объем V. Будем измерять температуру в энергетических единицах - не будет фигурировать постоянная Больцмана. Каждый атом газа имеет среднюю кинетическую энергию теплового движения, равную 3Т/2. Поэтому полная тепловая энергия газа равна

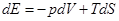

Известно, что давление газа равно p = nT. Если газ может обмениваться теплом с внешней средой, то закон сохранения энергии газа выглядит так:

. (5)

. (5)

Таким образом, изменение внутренней энергии газа может происходить как за счет совершаемой им работы, так и вследствие поступления некоторого количества тепла dQ извне. Это уравнение выражает первое начало термодинамики, т.е. закон сохранения энергии. При этом предполагается, что газ находится в равновесии, т.е. p = const по всему объему.

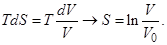

Если же допустить, что газ находится и в состоянии ТД равновесия, Т = const, то соотношение (5) можно рассматривать как элементарный процесс вариации параметров газа при их очень медленном изменении, когда ТД равновесие не нарушается. Именно для таких процессов и вводится понятие энтропии S с помощью соотношения

(6)

(6)

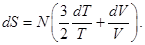

Таким образом, утверждается, что у равновесного газа кроме внутренней энергии есть еще одна внутренняя характеристика, связанная с тепловым движением атомов. Согласно (5, 6) при постоянном объеме dV = 0, изменение энергии пропорционально изменению температуры, а в общем случае

Так как  где N = nV = const есть полное количество атомов газа, то последнее соотношение можно записать в виде

где N = nV = const есть полное количество атомов газа, то последнее соотношение можно записать в виде

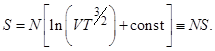

После интегрирования получаем

Выражение в квадратных скобках представляет собой энтропию, приходящуюся на одну частицу.

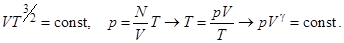

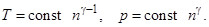

Таким образом, если и температура и объем изменяются таким образом, что VT3/2 остается постоянным, то и энтропия S не изменяется. Согласно (6) это означает, что газ не обменивается теплом с внешней средой, т.е. газ отделен от нее теплоизолирующими стенками. Такой процесс называется адиабатическим.

Поскольку

где  = 5/3 называется показателем адиабаты. Таким образом при адиабатическом процессе температура и давление изменяются с плотностью по закону

= 5/3 называется показателем адиабаты. Таким образом при адиабатическом процессе температура и давление изменяются с плотностью по закону

Формула Больцмана

Как следует из теоремы Лиувилля, функция распределения ? имеет резкий максимум при Е = Е0 (среднее значение) и отлична от нуля только в окрестности этой точки. Если ввести ширину  Е кривой

Е кривой  (Е), определив ее как ширину прямоугольника, высота которого равна значению функции

(Е), определив ее как ширину прямоугольника, высота которого равна значению функции  (Е) в точке максимума, а площадь равна единице

(Е) в точке максимума, а площадь равна единице  (при надлежащей нормировке). Можно перейти от интервала значений энергии к числу состояний

(при надлежащей нормировке). Можно перейти от интервала значений энергии к числу состояний  Г с энергиями, принадлежащими

Г с энергиями, принадлежащими  Е (это, фактически, средняя флуктуация энергии системы). Тогда величина

Е (это, фактически, средняя флуктуация энергии системы). Тогда величина  Г характеризует степень размазанности макроскопического состояния системы по ее микроскопическим состояниям. Другими словами, для классических систем

Г характеризует степень размазанности макроскопического состояния системы по ее микроскопическим состояниям. Другими словами, для классических систем  Г - это размер той области фазового пространства, в которой данная подсистема проводит почти все время

Г - это размер той области фазового пространства, в которой данная подсистема проводит почти все время  В квазиклассической теории устанавливается соответствие между объемом области фазового пространства и приходящимся на него числом квантовых состояний.. А именно, на каждое квантовое состояние в фазовом пространстве приходится клетка с объемом

В квазиклассической теории устанавливается соответствие между объемом области фазового пространства и приходящимся на него числом квантовых состояний.. А именно, на каждое квантовое состояние в фазовом пространстве приходится клетка с объемом  , где s - число степеней свободы

, где s - число степеней свободы

Величину  Г называют статистическим весом макроскопического состояния, его можно записать в виде:

Г называют статистическим весом макроскопического состояния, его можно записать в виде:

.

.

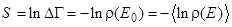

Логарифм статистического веса называется энтропией:

.

.

где  - статистический вес = число микросостояний, охватываемых рассматриваемым макросостоянием системы.

- статистический вес = число микросостояний, охватываемых рассматриваемым макросостоянием системы.

.

.

В квантовой статистике показывается, что  = 1. Тогда

= 1. Тогда

, где под

, где под  понимается статистическая матрица (плотности). Ввиду линейности логарифма функции распределения по энергии (*)

понимается статистическая матрица (плотности). Ввиду линейности логарифма функции распределения по энергии (*)  , где усреднение проводится по функции распределения

, где усреднение проводится по функции распределения  .

.

Поскольку число состояний  во всяком случае не меньше единицы, то энтропия не может быть отрицательной. S определяет густоту уровней энергетического спектра макроскопической системы. Ввиду аддитивности энтропии можно сказать, что средние расстояния между уровнями макроскопического тела экспоненциально убывают с увеличением его размеров (т.е. числа частиц в нем). Наибольшее значение энтропии соответствует полному статистическому равновесию.

во всяком случае не меньше единицы, то энтропия не может быть отрицательной. S определяет густоту уровней энергетического спектра макроскопической системы. Ввиду аддитивности энтропии можно сказать, что средние расстояния между уровнями макроскопического тела экспоненциально убывают с увеличением его размеров (т.е. числа частиц в нем). Наибольшее значение энтропии соответствует полному статистическому равновесию.

Характеризуя каждое макроскопическое состояние системы распределением энергии между различными подсистемами, можно сказать, что ряд последовательно проходимых системой состояний соответствует все более вероятному распределению энергии. Это возрастание вероятности велико в силу его экспоненциального характера eS - в экспоненте стоит аддитивная величина - энтропия. Т.о. процессы, протекающие в неравновесной замкнутой системе, идут таким образом, что система непрерывно переходит из состояний с меньшей энтропией в состояния с большей энтропией. В итоге энтропия достигает наибольшего возможного значения, соответствующего полному статистическому равновесию.

Таким образом, если замкнутая система в некоторый момент времени находится в неравновесном макроскопическом состоянии, то наиболее вероятным следствием в последующие моменты времени будет монотонное возрастание энтропии системы. Это - второй закон термодинамики (Р.Клаузиус, 1865г.). Его статистическое обоснование дано Л.Больцманом в 1870г. Другое определение:

если в некоторый момент времени энтропия замкнутой системы отлична от максимальной, то в последующие моменты энтропия не убывает. Она увеличивается или в предельном случае остается постоянной. Соответственно этим двум возможностям все происходящие с макроскопическими телами процессы принято делить на необратимые и обратимые. Необратимые - те процессы, которые сопровождаются увеличением энтропии всей замкнутой системы (процессы, которые бы являлись их повторениями в обратном порядке, не могут происходить, так как при этом энтропия должна была бы уменьшаться). Заметим, что уменьшение энтропии может быть вызвано флуктуациями. Обратимыми называются процессы, при которых энтропия замкнутой системы остается постоянной и которые, следовательно, могут проходить и в обратном направлении. Строго обратимый процесс представляет собой идеальный предельный случай.

При адиабатических процессах система не поглощает и не отдает тепло ?Q = 0.

Замечание: (существенное). Утверждение о том, что замкнутая система должна в течение достаточно длительного времени (большего, чем время релаксации) перейти в состояние равновесия относится лишь к системе, находящейся в стационарных внешних условиях. Пример - поведение доступной нашему наблюдению большой области Вселенной (свойства природы не имеют ничего общего со свойствами равновесной системы).

Информация.

Рассмотрим ленту, разбитую на ячейки - классический регистр. Если в каждой ячейке может быть помещен только один из двух символов, то говорят, что в ячейке содержится бит информации. Очевидно (см. лекцию 1), что в регистре, содержащем N ячеек содержится N бит информации и в нем можно записать 2N сообщений. Итак, информационная энтропия измеряется в битах:

(7)

(7)

Здесь QN = 2N - полное число различных сообщений. Из (7) ясно, что информационная энтропия просто равна минимальному числу двоичных ячеек, с помощью которых можно записать некую информацию.

Определение (7) можно переписать по-другому. Пусть у нас имеется множество QN различных сообщений. Найдем вероятность того, что необходимое нам сообщение совпадет со случайно выбранным из общего числа QN различных сообщений. Она равна, очевидно, PN = 1/QN. Тогда определение (7) запишется как:

(8)

(8)

Чем больше число ячеек N, тем меньше вероятность PN и тем больше информационная энтропия HB, содержащейся в данном конкретном сообщении.

Пример. Число букв алфавита равно 32 (без буквы ё). Число 32 есть пятая степень двойки 32 = 25. Чтобы каждой букве сопоставить определенную комбинацию двоичных чисел необходимо иметь 5 ячеек. Добавив к строчным буквам заглавные, мы удваиваем число символов, которые хотим закодировать - их станет 64 = 26 - т.е. добавляется лишний бит информации HB = 6. Здесь HB - объем информации, приходящийся на одну букву (строчную или заглавную). Однако такой прямой подсчет информационной энтропии не совсем точен, поскольку в алфавите есть буквы, которые встречаются реже или чаще. Тем буквам, которые встречаются реже, можно отдать большее количество ячеек, а на часто встречающихся буквах - сэкономить и отдать им те состояния регистра, которые занимают меньшее количество ячеек. Точное определение информационной энтропии было дано Шенноном:

(9)

(9)

Формально вывод этого соотношения можно обосновать следующим образом.

Мы показали выше, что

из-за аддитивности логарифма функции распределения и его линейности по энергии.

Пусть p - функция распределения какой-нибудь дискретной величины fi (например, буквы “о” в этом тексте). Если с помощью функции p построить функцию распределения вероятностей различных значений величины f = f1, f2,...fN , то эта функция будет иметь максимум при  , где

, где  и

и  (нормировка). Тогда p(

(нормировка). Тогда p( )

) = 1 и

= 1 и  (вообще говоря, это справедливо для класса функций, удовлетворяющих условию (*))

(вообще говоря, это справедливо для класса функций, удовлетворяющих условию (*))

Суммирование ведется по всем символам (буквам алфавита), а pi означает вероятность появления символа с номером i. Как видно это выражение охватывает как часто используемые буквы, так и буквы, вероятность появления которых в данном сообщении мала.

Поскольку в выражении (9) используется натуральный логарифм, соответствующую единицу информации называют “нат”.

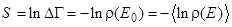

Выражение (9) можно переписать в виде

, (10)

, (10)

где скобки означают обычное классическое усреднение с помощью функции распределения pi.

Замечание. В следующих лекциях будет показано, что для квантовых состояний

(11)

(11)

где  - матрица плотности. Формально выражения (10) и (11) совпадают, однако есть и существенная разница. Классическое усреднение производится по ортогональным (собственным) состояниям системы, в то время как для квантового случая состояния могут быть и неортогональные (суперпозиции). Поэтому всегда Hquant

- матрица плотности. Формально выражения (10) и (11) совпадают, однако есть и существенная разница. Классическое усреднение производится по ортогональным (собственным) состояниям системы, в то время как для квантового случая состояния могут быть и неортогональные (суперпозиции). Поэтому всегда Hquant  Hclass !

Hclass !

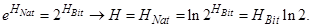

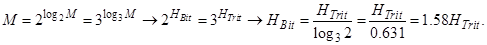

В формулах (8) и (9) используются логарифмы при разных основаниях. В (8) - по основанию 2, а в (9) - по основанию е. Соответствующие этим формулам информационные энтропии можно легко выразить друг через друга. Воспользуемся соотношением, в котором M - произвольное число

.

.

Тогда, учтя, что  а

а  получаем

получаем

Откуда

- число бит почти в полтора раза больше числа нат!

- число бит почти в полтора раза больше числа нат!

Рассуждая аналогично, можно получить соотношение между энтропиями, выраженными в тритах и битах:

В компьютерной технике пользуются информацией по двоичному основанию (в битах). Для рассуждений в физике удобнее пользоваться информацией по Шеннону (в натах), которой можно характеризовать любую дискретную информацию. Всегда можно найти число соответствующих бит.

СВЯЗЬ ЭНТРОПИИ И ИНФОРМАЦИИ. Демон Максвелла

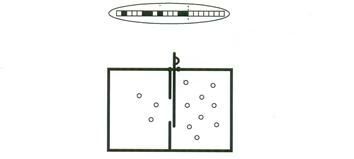

Этот парадокс впервые был рассмотрен Максвеллом в 1871г (см. рис.1). Пусть некая “сверхъестественная” сила открывает и закрывает заслонку в сосуде, перегороженном на две части и содержащем газ. Заслонка управляется по правилу: она открывается, если быстрые молекулы, двигающиеся справа налево, соприкасаются с ней или, если медленные молекулы ударяют в нее, двигаясь в противоположном направлении. Таким образом демон вводит разницу температур между двумя объемами без совершения работы, что нарушает второе начало термодинамики.

Рис.1.

Демон Максвелла. Демон устанавливает разность давления открывая заслонку, когда число молекул газа, ударивших в нее слева превышает число ударов справа. Это можно сделать полностью обратимым способом до тех пор, пока в памяти демона сохраняются случайные результаты его наблюдений за молекулами. Поэтому память демона (или его голова) нагревается. Необратимый шаг состоит не в том, что накапливается информация, а в том, что информация теряется, когда демон потом очищает память. Сверху: заполнение памяти демона битами информации – это случайный процесс. По правую сторону от пунктира – незаполненная область памяти (все ячейки находятся в состоянии 0, слева – случайные биты). Внизу – демон.

Был предпринят целый ряд попыток разрешить парадокс или изгнать демона. Например, предполагалось, что демон не может извлечь информацию без совершения работы или без возмущения (т.е. нагрева) газа – но, оказалось, что это не так! Другие попытки сводились к тому, что второе начало может нарушаться под действием неких «разумных» или “мыслящих” сил (существ). В 1929г. Лео Сцилард существенно «продвинул» решение проблемы, сведя ее к минимальной формулировке и выделив существенные компоненты. Главное, что нужно сделать Демону это установить находится ли единичная молекула справа или слева от скользящей заслонки, что позволило бы извлекать тепло. Такое устройство было названо двигателем Сциларда. Однако Сцилард не разрешил парадокса, поскольку его анализ не учитывал, как измерение, посредством которого демон узнает находится ли молекула справа или слева, влияет на увеличение энтропии (см рисунок Szilard_demon.pdf). Двигатель работает по шести-шагвому циклу. Двигатель представляет собой цилиндр, в торцах которого помещены поршни. В середину вставляется заслонка. Работа по вдвиганию перегородки может быть сведена к нулю (это показал Сциллард). Также имеется устройство памяти (УП). Оно может находиться в одном из трех состояний. «Пусто», «Молекула справа» и «Молекула слева». Исходное состояние: УП= «Пусто», поршни – отжаты, перегородка – выдвинута, у молекулы есть средняя скорость, которая определяется температурой термостата (слайд 1).

1. перегородка вставляется, оставляя молекулу справа или слева (слайд 2).

2. Устройство памяти определяет, где находится молекула и переходит в состояние «справа» или «слева».

3. Сжатие. В зависимости от состояния УП происходит вдвигание поршня со стороны, где нет молекулы. Этот этап не требует совершение работы. Поскольку сжимается вакуум (слайд 3).

4. Перегородка удаляется. Молекула начинает оказывать давление на поршень (слайд 4).

5. Рабочий ход. Молекула ударяется в поршень, заставляя его двигаться в обратном направлении. Энергия молекулы передается поршню. При движении поршня ее средняя скорость должна уменьшаться. Однако этого не происходит, поскольку стенки сосуда находятся при постоянной температуре. Поэтому тепло от термостата передается молекуле, поддерживая ее скорость постоянной. Таким образом во время рабочего хода происходит преобразование тепловой энергии, поступаемой из термостата в механическую работу, совершаемую поршнем (слайд 6).

6. Очищение УП, возвращая ее в состояние «Пусто» (слайд 7). Цикл завершен (слайд 8 = слайд 1).

Удивительно, что этот парадокс не был разрешен до 80-ых годов 20-го века. За это время было установлено, что в принципе, любой процесс можно сделать обратимым образом, т.е. без «оплаты» энтропией. Наконец, Беннетт в 1982г. установил окончательную связь между этим утверждением и парадоксом Максвелла. Он предложил, что демон на самом деле может узнать, где находится молекула в двигателе Сциларда без совершения работы или увеличения энтропии окружения (термостата) и таким образом, совершить полезную работу за один цикл работы двигателя. Однако, информация о положении молекулы должна оставаться в памяти демона (рси.1). По мере выполнения большего числа циклов все больше и больше информации накапливается в памяти. Для завершения термодинамического цикла демон должен стереть информацию, запасенную в памяти. Именно эту операцию стирания информации приходится классифицировать как процесс увеличения энтропии окружения, как требуется вторым началом. На этом завершается принципиально физическая часть устройства демона Максвелла.

Некоторое развитие этих идей получило в работах Д.Д.Кадомцева.

Рассмотрим идеальный газ, состоящий только из одной частицы (Кадомцев, «динамика и информация»). Это не абсурд. Если одна частица заключена в сосуде объемом V со стенками, находящимися при температуре Т, то рано или поздно она придет в равновесие с этими стенками. В каждый момент времени она находится во вполне определенной точке пространства и с вполне определенной скоростью. Будем проводить все процессы настолько медленно, что частица успеет в среднем заполнить весь объем и многократно поменять величину и направление скорости при неупругих столкновениях со стенками сосуда. Таким образом, частица оказывает на стенки среднее давление, имеет температуру Т и ее распределение по скоростям является максвелловским с температурой Т. Эту систему из одной частицы можно адиабатически сжимать, можно менять ее температуру, давая ей возможность прийти в равновесие со стенками сосуда.

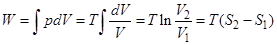

Среднее давление на стенку при N = 1, равно p = T/V, а средняя плотность n = 1/V. Рассмотрим случай изотермического процесса, когда Т = const. Из первого начала при Т = const. и p = T/V получаем

, поскольку

, поскольку

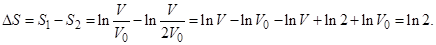

Отсюда находим, что изменение энтропии не зависит от температуры, так что

Здесь введена постоянная интегрирования: “размер частицы”<<V0<<V - чтобы не нарушалось приближение идеального газа.

Работа при изотермическом процессе

работа определяется разностью энтропий.

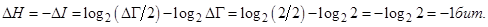

Пусть у нас имеются идеальные перегородки, которыми можно поделить сосуд на части без затраты энергии. Разделим наш сосуд на две равные части с объемом V/2 каждая. При этом частица будет находиться в одной из половин - но мы не знаем в какой. Допустим, что у нас есть прибор, который позволяет определить в какой из частей находится частица, например, прецизионные весы. Тогда из симметричного распределения вероятностей 50% на 50% нахождения в двух половинках мы получаем 100% вероятности для одной из половин - происходит “коллапс” распределения вероятностей. Соответственно, новая энтропия  окажется меньше исходной энтропии на величину

окажется меньше исходной энтропии на величину

За счет уменьшения энтропии можно совершить работу. Для этого достаточно двигать перегородку в сторону пустого объема вплоть до его исчезновения. Работа будет равна  Если бы во внешнем мире ничего не менялось, то повторяя эти циклы, можно построить вечный двигатель второго рода. Это и есть демон Максвелла в варианте Сцилларда. Но второй закон термодинамики запрещает получение работы только за счет тепла. Значит во внешнем мире должно что-то происходить. Что же это? Обнаружение частицы в одной из половин меняет информацию о частице - из двух возможных половинок указывается только одна, в которой находится частица. Это знание соответствует одному биту информации. Процесс измерения уменьшает энтропию частицы (перевод в неравновесное состояние) и ровно настолько же увеличивает информацию о системе (частице). Если совершать повторные деления пополам полученной ранее половинки, четвертушки, восьмушки и т.д., то энтропия будет последовательно уменьшаться, а информация - увеличиваться! Другими словами

Если бы во внешнем мире ничего не менялось, то повторяя эти циклы, можно построить вечный двигатель второго рода. Это и есть демон Максвелла в варианте Сцилларда. Но второй закон термодинамики запрещает получение работы только за счет тепла. Значит во внешнем мире должно что-то происходить. Что же это? Обнаружение частицы в одной из половин меняет информацию о частице - из двух возможных половинок указывается только одна, в которой находится частица. Это знание соответствует одному биту информации. Процесс измерения уменьшает энтропию частицы (перевод в неравновесное состояние) и ровно настолько же увеличивает информацию о системе (частице). Если совершать повторные деления пополам полученной ранее половинки, четвертушки, восьмушки и т.д., то энтропия будет последовательно уменьшаться, а информация - увеличиваться! Другими словами

Чем больше известно о физической системе, тем меньше ее энтропия. Если о системе известно все - это значит, что мы перевели ее в сильнонеравновесное состояние, когда ее параметры максимально удалены от равновесных значений. Если в нашей модели частицу удастся поместить в элементарную ячейку объема V0, то при этом S = 0, а информация достигает своего максимального значения  поскольку вероятность pmin найти частицу в данной ячейке равна V0/V. Если в последующие моменты времени частица начнет заполнять больший объем, то информация будет утрачиваться, а энтропия - расти. Подчеркнем, что за информацию нужно платить (по второму началу) увеличением энтропии Se внешней системы, причем

поскольку вероятность pmin найти частицу в данной ячейке равна V0/V. Если в последующие моменты времени частица начнет заполнять больший объем, то информация будет утрачиваться, а энтропия - расти. Подчеркнем, что за информацию нужно платить (по второму началу) увеличением энтропии Se внешней системы, причем  Действительно, если бы за один бит информации прибор (внешняя система) увеличивал свою энтропию на величину

Действительно, если бы за один бит информации прибор (внешняя система) увеличивал свою энтропию на величину  меньшую одного бита, то мы могли бы обратить тепловую машину. А именно, расширяя объем, занятый частицей, мы бы увеличивали ее энтропию на величину ln2, получая работу Tln2, а суммарная энтропия системы частица плюс прибор уменьшилась бы. Но это невозможно по второму началу. Формально,

меньшую одного бита, то мы могли бы обратить тепловую машину. А именно, расширяя объем, занятый частицей, мы бы увеличивали ее энтропию на величину ln2, получая работу Tln2, а суммарная энтропия системы частица плюс прибор уменьшилась бы. Но это невозможно по второму началу. Формально,  , поэтому уменьшение энтропии системы (частицы)

, поэтому уменьшение энтропии системы (частицы)  сопровождается увеличением энтропии прибора

сопровождается увеличением энтропии прибора  .

.

Итак, информационная энтропия - это мера недостатка (или степень неопределенности) информации о действительном состоянии физической системы.

Информационная энтропия Шеннона:

, где

, где  (это относится к двухуровневым системам, типа бит: “0” и “1”. Если размерность равна n, то H = logn

(это относится к двухуровневым системам, типа бит: “0” и “1”. Если размерность равна n, то H = logn . Так, для n = 3, Н = log3

. Так, для n = 3, Н = log3 причем,

причем,  = 3.)

= 3.)

Количество информации I (или просто информация) о состоянии классической системы, получаемое в результате измерений внешним прибором, связанным с рассматриваемой системой некоторым каналом связи, определяется как разность информационной энтропии, соответствующей начальной неопределенности состояния системы H0, и информационной энтропии конечного состояния системы после измерения H. Таким образом,

I + H = H0 = const.

В идеальном случае, когда отсутствуют шумы и помехи, создаваемые внешними источниками в канале связи, конечное распределение вероятностей после измерения сводится к одному определенному значению pn = 1, т.е. H = 0, а максимальное значение полученной при измерении информации будет определяться : Imax = H0. Таким образом, информационная энтропия Шеннона системы имеет смысл максимальной информации, заключенной в системе; она может быть определена в идеальных условиях измерения состояния системы в отсутствие шумов и помех, когда энтропия конечного состояния равна нулю:

H = 0.

Рассмотрим классический логический элемент, который может находиться в одном из двух равновероятных логических состояний “0” и “1”. Такой элемент вместе с окружающей средой - термостатом и генерируемым внешним теплоизолированным объектом сигналом единую неравновесную замкнутую систему. Переход элемента в одно из состояний, например, в состояние “0”, соответствует уменьшению стат. веса его состояния по сравнению с начальным состоянием в 2 раза (для трехуровневых систем - в 3 раза). Найдем уменьшение информационной энтропии Шеннона, которое соответствует увеличению количества информации об элементе на единицу, которая называется битом:

Рекомендуем посмотреть лекцию "14 Методы и алгоритмы трехмерной графики".

Следовательно, информационная энтропия определяет число битов, которое требуется для кодирования информации в рассматриваемой системе или сообщении.

ЛИТЕРАТУРА

1. Д.Ландау, И.Лифшиц. Статистическая физика. Часть 1. Наука, М 1976.

2. М.А.Леонтович. Введение в термодинамику. Статистическая физика. Москва, Наука, 1983. - 416с.

3. Б.Б.Кадомцев. Динамика и информация. УФН, 164, №5, 449 (1994).