Основные соотношения теории вероятностей

Основные соотношения теории вероятностей, как это ни покажется парадоксальным, выглядят боолее естественно и гораздо более понятны, ее ли они рассматриваются не в дискретном, а в непрерывном выборочном пространстве, в котором определение вероятности дается через теорию меры и интегрирование. В связи с этим основные положения теории веро ятностей мы рассмотрим в пространстве Rn. Как уже говорилось, в дискретных выборочных пространствах вероятность приписывается веем подмножествам, в то время как в непрерывных пространствах подобный подход неприемлем, так как приводит к противоречиям. Соответственно и не всякая функция на непрерывном пространстве может рассматриватьс. в качестве случайной величины. Для большинства приложений достаточно ограничиться s-алгеброй борелевских множеств и беровскими функция ми, измеримыми относительно этой s-алгебры U.

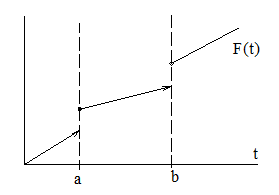

Определение 2.1. Функция точки F(t) на прямой есть функция распределения некоторой случайной величины, если она

а) неубывающая функция, т.е. F(a)£F(b) при а < b ;

в) непрерывна справа, т.е. F(а) = F(а+) ;

с) удовлетворяет условиям F(- ¥ ) = 0, F(¥) = I.

Между вероятностной мерой Р, определенной на s-алгебре подмножеств из R1 и вероятностной функцией распределения F(t) имеет место отношение

F(t)=P{x £ t}.

Полагая t = а и t = b, получаем

Рекомендуемые материалы

F(b)-F(a)=P{a<X£b}=P{(a,b]}

Вероятность попадания случайной величины Х в интервал (a,b] можно также обозначать посредством. Соответственно, можно написать: F{(а,b]}=F(b)-F(a-), F{(a,b)]=F(b-)-F(a), F{[a,b)}=F(b-)-F(a-).

Понятие функции распределения можно обоощить и на многомерные пространства. В Rn функция распределения F(х) является функцией точки х = (х1,..., хn)ÎRn. А в общем случае можно показать, что по заданной в Rn функции точки можно построить аддитивную функцию F{(a,b]} промежутка (а,в] по формуле

(2.1)

(2.1)

где с = (с1,..., сn ) - это множество всех угловых точек промежутка

(а,в], т.е. точек сi=аi, и сj= bj, , а l(c) - число входящих в с компонент аj. Например, для пространства R2 получаем

F{(а,b]} = F(b1,b2) - F(а1, b2) - F(b1,a2) + F(а1,а2 ).

Понятно, что в многомерном случае функции распределения становятся весьма неудобными для использования . Из формулы (2.1) видно, что любая функция распределения порождает вероятностную меру на s-алгебре борелевских множеств в Rn .

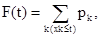

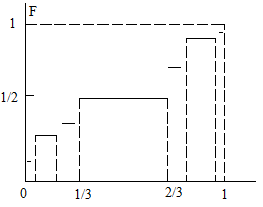

Рассмотрим дискретные случайные величины, т.е. такие, которые принимают только конечное или счетное множество значений х1, х2, ..., хn,...- с вероятностями Pk>0, т.е. pk=P{X=xk}. Распределение подобных случайных величин описывается функцией

Легко видеть, что функция распределения дискретных случайных величин кусочно-постоянна и величина ее скачков в точках хk равна F(xk+0) - F(хk - 0) = рk .

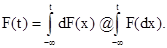

Если же случайные величины непрерывно распределены на вещественной оси, то функция их вероятностного распределения будет задаваться интегралом типа Лебега-Стилтьеса:

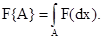

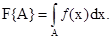

Очевидно, F(¥) = I. Если же случайные величины распределены на некотором подмножестве А в R1, то можно записать

Если существует такая интегрируемая по Лебегу функция ¦(x), что

то говорят, что функция Fабсолютно непрерывна относительно меры Лебега, а функцию ¦(x) называют плотностью (или производной Радона-Никодима) функции F относительно меры Лебега. Согласно теореме Радона-Hикодима, распределение F абсолютно непрерывно относительно меры Лебега тогда и только тогда, когда для любых подмножеств A оси R1 нуле вой длины оказывается F{A}=0.

Говорят, что вероятностное распределение F сингулярно относительно меры Лебега, если оно сосредоточено на множестве меры Лебега нуль т.е. на множестве нулевой протяженности.

Теорема Лебега о разложении. Любое вероятностное распределение F является смесью атомического (дискретного), абсолютно непрерывного и сингулярного непрерывного распределений.

Примером сингулярного непрерывного распределения является функция Кантора

Эта функция является кусочно-постоянной, возрастающей лишь на множестве Лебега нуль, представляющем собой совершенное множество (замкнутое и плотное в себе), т.е. содержащее все свои предельные точки и одновременно содержащееся во множестве всех своих предельных точек, причем это совершенное множество нигде не плотно, т.е. его замыкание не содержит открытого множества.

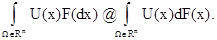

Интеграл Лебега-Стилтьеса удовлетворяет всем свойствам обычного интеграла Лебега и для интегрируемых функций U(х) записывается в виде (на Rn) :

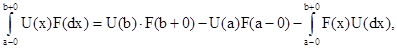

Для распределений в R1 имеет место следующая формула интегрирования по частям:

где в отношении функции U(х) предполагается, что она является функцией ограниченной вариации и непрерывна в тех точках в которых F(x) разрывна.

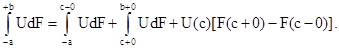

Если функция U(х) непрерывна, а функция распределения F(х) терпит разрыв в точке сÎ(а,b), то имеет место представление:

На практике редко когда бывает известно вероятностное распределение случайной величины,и для получения всевозможного рода оценок пользуются некоторыми количественными характеристиками случайных величин, среди которых наиболее важны математическое ожидание, дисперсия и моменты различных порядков (³ 2).

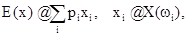

Понятие математического ожидания, или среднего ожидаемого значения пришло из теории игр, где под этим понятием подразумевается ожидаемы выигрыш в игре. Определим это понятие сначала для дискретного случая Пусть wi элементарные события из некоторого дискретного выборочного пространства W, вероятность появления i-го из которых имеет величину рi. Тогда под математическим ожиданием cлучайной величины понимается величина E(х), определяемая рядом

причем этот ряд предполагается абсолютно сходящимся. Если же ряд не сходится абсолютно, то операция усреднения (определения математического ожидания) теряет смысл.

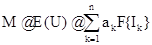

Приведенное определение математического ожидания для дискретного ны борочного пространства нетрудно распространить на континуумиальные выборочные пространства, например, на подмножества W. Пространства Rn Сначала это распространение целесообразно провести для случая наиболее простого представления случайной величины U, задаваемой ступенчатой функцией U(х), принимающей значения a1,…,an . По аналогии с дискретным случаем математическое ожидание будет задаваться

где Ik - интервалы, на которых функция U(х) принимает значения ak, a F{Ik}- вероятности реализации значений ak .

Математическое ожидание Е(U) обладает следующими свойствами:

а) Линейностью: Е(a1U1+ a2) = a1Е (U1) + a2Е(U2);

в) Положительностью: Е( U ) > 0 при U³0;

с) Нормированностью: Е(1) = 1.

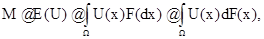

Вышеопределенное математическое ожидание Е(U) можно продолжить на более широкий класс функций с сохранением свойств а)-с). Известно, что непрерывные функции можно рассматривать как предел последовательности ступенчатых функций, a эти последние можно продолжить до бэровски функций. В этом случае математическое ожидание определяется при замене конечных сумм интегралом Лебега-Стилтьеса :

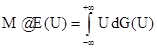

где предполагается абсолютная сходимость интеграла.

Из свойств интеграла следует, что математическое ожидание постоянной равно этой постоянной и математическое ожидание суммы случайных величин равно сумме их математических ожиданий. Столь же естественно из свойств интеграла следует, что математическое ожидание произведени независимых случайных величин равно произведению их математических ожиданий.

Математическое ожидание можно определить, вообще говоря, двумя способами. Выше мы определили его как интеграл  , где F(х) - распределение вероятностей на множестве W. Однако U(х), как функция переменной х, распределенной по закону F(х) на множестве W, сама является случайной величиной, значения которой распределены на оси R1 с некоторой вероятностью G(U), индуцируемой вероятностью F(х). Следовательно, математическое ожидание случайной величины Х = U(х) можно также записать в виде

, где F(х) - распределение вероятностей на множестве W. Однако U(х), как функция переменной х, распределенной по закону F(х) на множестве W, сама является случайной величиной, значения которой распределены на оси R1 с некоторой вероятностью G(U), индуцируемой вероятностью F(х). Следовательно, математическое ожидание случайной величины Х = U(х) можно также записать в виде

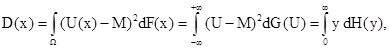

Наряду с математическим ожиданием, большую роль в приложениях играет еще одна характеристика случайных величин - дисперсия, представляющая собой математическое ожидание квадрата уклонения случайной величины Х = U(х) от ее математического ожидания М = E(U). Но опред лению, дисперсия D(Х) равна

где F(х) - функция распределения на множестве W , G(U) –функция распределения значений U(х) и Н(у) - функция распределения случайной величины (U - М)2.

Очевидно, дисперсия постоянной величины С равна нулю.

Предложение 2.1. Дисперсия суммы двух независимых случайных величин Х и Y

равна сумме их дисперсий.

Доказательство. Из независимости Х и Y следует независимость также и разностей (X - Е(Х)) и (Y - Е(Y)). Tогда утверждение следует из следующей цепочки элементарных преобразований:

D(X + У) = Е[(Х+У - Е( Х+У)]2 = E[Х+У - Е(Х) - Е(У)]2 = Е [(X - Е(Х))+ (У - Е(У))]2 =

= DХ +DУ + 2 Е[(Х - Е(Х))( У - Е(У)] = DX + DУ + 2 Е(Х - Е(Х))·Е(У - Е(У)) .

ë=0 ë=0

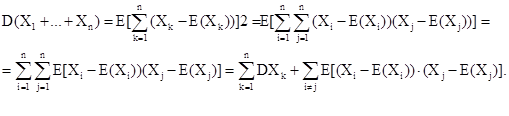

Следствие 2.1. Если X1 ,..., Xn - случайные величины, каждая из которых независима от суммы остальных, то дисперсия их суммы равна сум ме дисперсий каждой из них.

Следствие 2.2. дисперсия суммы конечного числа попарно независимых случайных величин Х1,..., Хn равна сумме их дисперсий.

Доказательство:

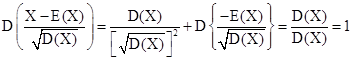

Нормированным уклонением случайной величины Х называется величина

Если воспользоваться тем, что случайные величины Х и (постоянная) Е(Х

независимы и что дисперсия постоянной равна нулю, то можно получить:

Нетрудно получить, что D(Х - У) =D(X)+D(y), где Х и Y - независимые случайные величины. В самом деле, D(- Y) = (-1)2 D(y) = D(Y)

В качестве аналога математического ожидания случайной величины мож но рассматривать центр масс стержня неоднородной массы, а механическим аналогом дисперсии может служить центральный момент инерции стержня. Чем больше масса стержня сосредоточена в окрестности его центра масс, тем меньше момент инерции, характеризующий разброс массы отно сительно центра масс; аналогично, с уменьшением разброса случайной величины относительно среднего значения уменьшается и дисперсия, характеризующая этот разброс.

На практике вместо дисперсии, имеющей размерность квадрата случайной величины, предпочитают пользоваться величиной

имеющей размерность самой случайной величины и называемой средним квадратическим отклонением.

Следует отметить, что на практике нередко удобнее рассчитывать дисперсию не по формуле Е( Х - Е(Х))2 по формуле,а получающейся из нее после возведения в квадрат величины (X - Е(Х)) и следующего упрощения с использованием свойств математического ожидани

D(Х) = Е( Х2 - 2 Х Е(Х) +[E(X)]2)= Е(Х2) - 2 Е(Х) Е(Х) +[Е(Х )]2= Е(Х2) – [Е(Х)]2 .

Эта формула аналогична известной формуле механики, определяющей момент инерции тела относительно любой оси через момент инерции относительно параллельной оси, проходящей через центр масс тела.

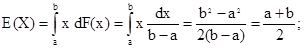

В качестве примера вычислим математическое ожидание и дисперсию случайной величины Х , равномерно распределенной в интервале (а,b):

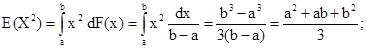

таким образом, математическое ожидание совпадает с серединой интервал подсчитаем теперь дисперсию по формуле: Е(Х2 ) – [Е(Х)]2 . Находим

подставляя в формулу для дисперсии Е(Х) и Е(Х2), получаем

Отсюда видно, что чем больше длина интервала (а,b), на котором распределена случайная величина X, тем больше дисперсия, т.е. дисперсия играет роль характеристики рассеяния случайной величины около математического ожидания.

3.

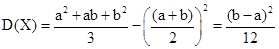

Математическое ожидание и дисперсию называют также моментами первого и второго порядка случайной величины X. Для многих приложений важны не только первые два момента, но и моменты более высоких порядков. Моментом к-го порядка случайной величины Х называется математическое ожидание величины (X - а)k , т.е.

Если а = 0, то момент называется начальным. Начальный момент первого порядка есть, очевидно, математическое ожидание. Если а = Е(X), то момент называется центральным. Нетрудно убедиться, что центральный момент первого порядка равен нулю, а центральный момент второго порядка есть дисперсия. Между центральными и начальными моментами суще ствуют относительно простые полиномиальные зависимости, которые могут быть получены в результате выполнения операций вычисления степеней, входящих в определение этих моментов. Несколько первых центральных и начальных моментов играют большую роль в статистике. Например, если известен закон распределения случайной величины с точностью до нескол ких постоянных, то эти постоянные могут быть найдены во многих случая с помощью нескольких первых моментов. Если же функция распределена неизвестна, то даже с помощью всех целочисленных моментов не представ ляется возможным ее определить, поскольку один и тот же набор счетного числа целочисленных моментов может относиться к различным функциям распределения. В связи с этим возникает проблема моментов; дана последовательность чисел с0 = I, с1 , с2 .... и требуется найти, при каких условиях существует такая функция распределения F(х), для которой при всех n имеют, место равенства  и когда эта функция единственна? В настоящее время эта задача решена.

и когда эта функция единственна? В настоящее время эта задача решена.

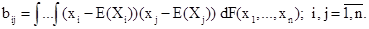

Дадим определение дисперсии n - случайных величин (Х1 , ..., Хn ), или , что то же самое, n-мерной случайной величины (Х1,…, Xn ). Дисперсией (или корреляционной матрицей) n-мерной случайной величины называется совокупность n2 чисел, определяемых по формулам:

Числа и представляют собой элементы неотрицательно определенной матрицы

,

,

диагональные элементы которой, как легко видеть, представляют собой дисперсии соответствующих случайных величин: bij = D(Xi).

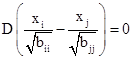

Числа bij при i¹j называются смешанными центральными моментами второго порядка случайных величин Xi, и Xj, . Очевидно, bij=bji. Коэфициенты bij обычно называют коэффициентами ковариации, а нормированные следующим образом коэффициенты ковариации

называют коэффициентами корреляции между случайными величинами Хi и Хj

Значения коэффициентов rij лежат в диапазоне [-1, 1] , причем значения ±1 достигаются только в случае линейной зависимости между Xi, и Xj, что нетрудно подсчитать непосредственно. В самом деле,

а следовательно, rijÎ[-1,1].

а следовательно, rijÎ[-1,1].

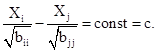

Равенство rij = 1 возможно в том и только том случае, если

поскольку это равенство имеет место одновременно с равенством (I - rij) = 0. Но дисперсия равна нулю только от постоянной величины следовательно,

A последнее равенство выражает линейную связь между. Аналогичная линейная связь лишь со знаком + вместо - в левой части имеет место для случая rij= - I.

Задав линейную связь между Хi и Хj , нетрудно подсчитать, что коэффициент корреляции между Хi и Xj равен ±1.

Таким образом, коэффициент корреляции служит как бы оценкой близости зависимости между случайными величинами к линейной. Для независимых случайных величин коэффициент корреляции равен нулю. Однак он может равняться нулю и для зависимых случайных величин. Например, пусть случайные величины Х и Y связаны параболической зависимостью Y = Х2 , т.е. на плоскости (х,у) случайные величинны (X,Y) распределены вдоль параболы, и пусть распределение вероятностей величины Х симметрично относительно начала координат. Тогда Е(Х) = 0 и интеграл, выражающий коэффициент корреляции, окажется симметричным относительно оси у, а следовательно, обратится в нуль.

Случайные величины называются коррелированными, если их корреляционныи момент не равен нулю, в противном случае они называются некоррелированными. Независимые случайные величины всегда не коррелирован Понятно, что в общем случае корреляционный момент случайных величин X и Y равен нулю, когда совместное распределение этих случайных величин Р(Х,Y) симметрично относительно хотя бы одной из прямых, парал лельных осям координат и проходящих через точку, определяющую их математические ожидания.

Итак, коэффициент корреляции не может служить характеристикой зани симости или независимости случайных величин. Равенство этого коэффициента нулю является лишь необходимым условием независимости, но не достаточным. В следующей теореме указывается необходимое и достатс ное условие независимости; правда, к сожалению, оно является мало пригодным для практической проверки.

Теорема 3.1. Случайные величины Х и Y являются независимыми в том и только том случае, если для любых непрерывных функций (на вещественной оси) f и, обращающихся в нуль вне конечного интервала, имеет место равенство:

Е(f(Х)y(Y)) = Е(f(Х))·Е(y(Y)).

Доказательство. Необходимость очевидна: при независимости величин математическое ожидание, представляющее соббй интеграл от пары функций, интегрируемых каждая по своей вероятностной мере, распадается на произведение интегралов. При доказательстве достаточности следуе вспомнить, что , по определению, случайные величины называются независимыми, если вероятность их совместной реализации равна произведению вероятностей каждой из них. Но из условия теоремы получаем что вероятность совместной реализации равна произведению вероятносте при fºyº1

Рассмотрим теперь вероятностные меры, функции распределения и математические ожидания на произвольных подмножествах конечномерног пространства и на произведении пространств. Приведенные ниже интегральные представления для случая плоскости понятным образом распрост раняются на многомерные пространства.

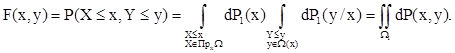

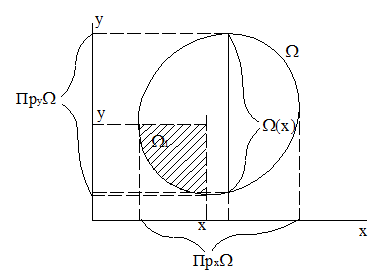

Пусть на множестве WÎR2 координатные величины Х и Y являются случайными. Их распределение нa W задается вероятностной мерой Р, определенной на s-алгебре подмножеств множества W. Вероятностная мера Р на множестве W, может быть записана в виде одного из следующих, равных друг другу интегралов:

(3.1.)

(3.1.)

где ПрxW - проекция множества W на ось x, W(x) - сечение множества W некоторой прямой х=const. Все пять введенных мер Р(х,у), Р1(х), P2(у), Р1(х/у) и Р2(у/х) являются вероятностными мерами. Меры Р1(х) и P2(y) называются маргинальными (проекциями мер Р на оси х и у), а меры Р1(х/у) и Р2(у/х) - условными мерами. Соответствующие этим мерам функции распределения вероятностей называются соответственна маргинальными и условными распределениями. Нетрудно основываясь на одной из трех приведенных форм интегрального представ ления вероятности, определить функции распределения F(x)= P(X £ x) и F(у)= Р(У £ у) или же функцию распределения F(х,у) = Р(Х £ х, Y £ у). Приведем, например, одно из возможных представлений для функции распределения F(х,у):

Область W1=WÇ (X£ x, Y£ Y )изображен на рис.

В приведенном подходе к анализу случайных величин Х и Y исходным понятием y нас являлась область W на плоскости (х,у) с определенной на ее подмножествах вероятностью P. Однако весьма часто бывает и наоборот: задаются независимые случайные величины Х и Y, каждое со свои собственным вероятностным распределением, т.е. исходными являются дв частных (маргинальных) распределения, а вероятности на плоскости (т.е. Р(х,у)) получаются из них с помощью произведений пространств. Рассмотрим два произвольных вероятностных (выборочных) пространства W1 и W2, на s-алгебрах U1 и U2 которых определены вероятностные меры P1 и Р2, соответственно. Можно, в частности, принять W1=Rm и W2=Rn. Пусть А1 - произвольное подмножество из W1, принадлежащее s-алгебре U1, а А2 - аналогичное подмножество W2. На произведении пространств W1´W2 рассмотрим множества вида A1´А2. Множества такого вида будем наделять вероятностями по правилу умножения:

Р(A1´А2) = Р1(A1)·Р2(А2).

Известно, что на наименьшей s-алгебре, содержащей все множества типа A1´А2, существует единственная вероятностная мера Р, такая, что вероятности «прямоугольников» задаются приведенным правилом умножения. Эта наименьшая s-алгебра обозначается U1´U2, а определенная на ней мера Р называется произведением мер Р1 и Р2.

Понятно, что в рассмотренном выше случае, когда мы сначала опреде ляли вероятности Р(х,у) на произведении пространств (х,у), а затем уже вводили маргинальные распределения Р1(х) и Р2(у), исходная s-алгебра U на (х,у) не могла быть меньше s-алгебры произведения.

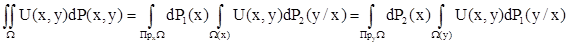

В общем случае случайными величинами мы назвали выше не сами элементы s-алгебры U, а функции U, определенные на W и измеримые относительно U (и, в частности, бэровские функции). В частном случае эти функции могут тождественно равняться единице; и тогда объектом исследования оказываются сами элементы s-алгебры - случайные величины. Записанное выше равенство (3.1) выражает собой частный случай теоремы Фубини о повторном интегрировании на произведении пространен когда рассматривается единичная функция. В более общем случае теорем Фубини утверждает существование повторных интегралов при выполнении весьма слабых требований к классу функций U(х,у), определенных на W (например, измеримых относительно алгебры-произведения) и к классу условных вероятностей (например, регулярных в определенном ниже смысле).Согласно этой теореме имеет место равенство (теорема умножения вероятностей):

Рекомендуем посмотреть лекцию "Подразделение паблик рилейшнз".

В отношении, например, первого из повторных интегралов в (3.2) регулярность условной вероятности означает, что интеграл

есть измеримая относительно s-алгебры U1 функция от х и есть вероятносная мера на s-алгебре U2.

Понятно, что левая часть равенств (3.2) определяет в общем случае математическое ожидание случайной величины U(х,у), определенной на подмножестве W некоторого конечномерного пространства, а правые части определяют два возможных представления математического ожидания в виде повторных интегралов. Внутренние интегралы в каждом из повторных интегралов в (3.2) определяют условные математические ожидания. Аналогичным образом строятся повторные интегралы на произведении более чем двух пространств.

Определенные проблемы возникают в связи с тем, что вероятности можно приписывать разным подмножествам выборочного пространства W. Наиболее широко распространенным подходом в теории вероятности является подход, при котором вероятности приписывают борелевским множествам Ub. Но возможны подходы, при которых s-алгебра является не первичным по отношению к вероятностной мере понятием, а вторичным, и некоторые из подобных подходов мы рассмотрим ниже. Некоторые из возникающих при этом проблем состояв в следующем. Например, в случае классического определения вероятностей на борелевских множествах Ub следует иметь в виду, что любое борелевскюе множество ВÎUb содержит неборелевские подмножества. Следовательно, множество борелевской меры нуль может содержать подмножества, на которых вероятности не определены. Т.е. ситуация оказывается странной: мы имеем множества нулевой меры, подмножества которых, вообще говоря, никак не оцениваются с точки зрения вероятности. Вообще говоря, эту неприятность нетрудно обойти, приняв, что если А Ì В и Р{В}=0 , то Р{А}=0. Подобное допущение требует расширения s-алгебры Ub до минимальной s-алгебры U, содержащей Ub и все подмножества нулевых множеств. Подобное расширение называется лебеговским пополнением исходного вероятностного пространства. Множество А принадлежит пополненной s-алгебре Ub тогда и только тогда, когда А-В и В-А содержатся в нулевом множестве. Лебеговское пополнение удобно в задачах, в которых задано всего одно распределение Р. Если же вероятностных рас ределений более одного, то возможны неприятности, связанные с тем, что, например, пополненная s-алгебра U, построеннная с применением распределения Р1, будет отличатьcя от пополненной s-алгебры,построенной с применением распределения Р2 , а следовательно, величины, случайные по отношению к одной из этих алгебр, перестанут быть таковыми по отношению к другой s-алгебре.