Меры количества информации

1.2. Меры количества информации

Теория информации изучает основные закономерности получения, передачи, хранения и обработки информации. Для этого необходимо определить какими способами можно измерять информацию и в каких единицах.

Информационные меры, как правило, рассматриваются в трех аспектах: структурном, статистическом и семантическом.

В структурном аспекте рассматривается строение массивов информации и их измерение простым подсчетом информационных элементов или комбинаторным методом. Структурный подход применяется для оценки возможностей информационных систем вне зависимости от условий их применения.

При статистическом подходе используется понятие энтропии как меры неопределенности, учитывающей вероятность появления и информативность того или иного сообщения. Статистический подход учитывает конкретные условия применения информационных систем.

Семантический подход позволяет выделить полезность или ценность информационного сообщения.

Структурные меры информации

Информация всегда представляется в виде сообщений. Элементарная единица сообщений - символ. Символы, собранные в группу, называется словом. Сообщение, оформленное в виде слова или отдельных символов, всегда передается в материально - энергетической форме (электрической, световой, звуковой сигналы и т. д.)

Структурные меры учитывают только дискретное строение информации. В структурной теории различают геометрическую, комбинаторную и аддитивную меры.

Рекомендуемые материалы

Геометрическая мера предполагает измерение параметра геометрической модели информационного сообщения (длины, площади, объема и т. п.) в дискретных единицах. Например, геометрической моделью информации в виде одноразрядного двоичного слова, принимающее значение 0 или 1может быть линия единичной длины (рис 1.1,а), двухразрядного слова - квадрат (рис. 1.1,б), трехразрядное слово - куб (рис 1.1,в).

Максимально возможное количество информации в заданных структурах отражает информационную емкость модели (системы), которая определяется как сумма дискретных значений по всем измерениям (координатам)–2,4,8 и т.д.

Комбинаторная мера. В комбинаторной мере количество информации вычисляется как количество различных комбинаций элементов, содержащихся в сообщении.

Во многих случаях дискретное сообщение можно рассматривать как слово, состоящее из некоторого количества элементов п, заданных алфавитом, состоящим из т элементов — букв, цифр или символов.

Определим количество различных сообщений, которые можно образовать с помощью заданного алфавита. Если сообщение состоит из двух элементов (n = 2), то всего может быть образовано m2 различных сообщений. Например, с помощью десяти цифр 0, 1, ..., 9 (m=10) может быть образовано 100 различных чисел от 00 до 99. Если количество элементов сообщения равно трем, то количество различных сообщений будет равно m3 и т. д.

Таким образом, при количестве элементов n число возможных различных сообщений L определится как

L=mn (1.1)

Чем больше L, тем большее количество возможных различных сообщений может быть передано источником. Поэтому величина L может быть принята в качестве меры количества информации. Однако выбор L в качестве меры количества информации связан с некоторыми неудобствами. Так, при n = 0 фактически никакое сообщение не передается и количество передаваемой информации равно нулю, однако мера L=m0=1.

Выбор L в качестве меры информации неудобен еще и тем, что при сложении количества информации от нескольких независимых источников сообщений не выполняется условие линейного сложения количеств информации, т. е. условие аддитивности. Действительно, если первый источник характеризуется числом L1=mn1 различных сообщениями, а второй — L2=mn2, то общее число различных сообщений, полученных от двух источников, определится произведением

L = L1 ´L2 =mn1´mn2= mn1+n2. (1.2)

Для k различных источников общее число возможных различных сообщений равно

L = L1 ´L2 ´... ´Lk. (1.3)

Аддитивная мера (мера Хартли). Хартли ввел логарифмическую меру количества информации, позволяющую оценивать количество информации, содержащейся в сообщении, логарифмом числа всевозможных сообщений:

I = logL. (1.4)

Согласно (1.4), при L = 1 I = 0, т. е. информация отсутствует. При использовании (1.2) и (1.4) получим:

I = logL = п log т. (1.5)

С увеличением числа элементов сообщения пропорционально возрастает количество информации I. Таким образом, логарифмическая мера обладает аддитивностью в отношении количества элементов сообщения. Если общее число источников информации равно k, то количество информации, передаваемое всеми источниками,

I = log I. = log L1+ logL2 + … + logLk , (1.6)

т. е.

I = I1+I2+...+ Ik. (1.7)

Таким образом, логарифмическая мера обладает аддитивностью по отношению к количеству элементов сообщения и по отношению к количеству источников сообщений.

Пример. Сообщения передаются 5-разрядным двоичным кодом. Определить количество информации, передаваемое одним сообщением.

Всего можно передать L = 25 = 32 различных сообщений. Количество информации в одном сообщении определяется как I = log L = log 25 = 5 log 2. Обычно пользуются двоичными логарифмами, что согласуется с представлением информации в ЭВМ. Тогда I = 5 log2 2 = 5.

Статистические меры информации

При статистическом (вероятностном) подходе получение конкретного количества информации рассматривается как результат определенного случайного выбора для передачи одного сообщения из множества возможных.

Теория информации исходит из того, что сообщения не известны заранее приемной стороне с полной определенностью. Заранее известно лишь множество, из которого могут быть выбраны эти сообщения: A={a1, a2, … , aL} и то, как часто выбирается для передачи то или иное из этих сообщений. Т. е. известны вероятности передачи этих сообщений p1, p2, … , pL. Эти вероятности представляют собой полную группу событий - сумма вероятностей всех сообщений равна единице, т. е.

p1 + p2 + … +pL= =1. (1.8)

=1. (1.8)

Пусть передача каждого из L сообщений равновероятна:

p1 = p2 = … =pL = p =  . (1.9)

. (1.9)

Тогда получим

I = log L = log = – log p, (1.10)

= – log p, (1.10)

т.е. количество информации в любом одном переданном сообщении определяется логарифмом вероятности его передачи со знаком минус.

Пример. Одноразрядный двоичный источник информации имеет L =21=2 (а1=0,а2=1) и p1 = p2 = 0,5. Тогда

I = I1 = I2 = –log2 0,5 = 1 бит.

В общем случае при приеме не равновероятных сообщений неопределенность появления конкретного i-го сообщения также характеризуется его вероятностью pi. Мерой количества информации, содержащейся в конкретном i- м сообщении является величина Ii = – log pi. График этой функции приведен на рис. 1.2.

В общем случае при приеме не равновероятных сообщений неопределенность появления конкретного i-го сообщения также характеризуется его вероятностью pi. Мерой количества информации, содержащейся в конкретном i- м сообщении является величина Ii = – log pi. График этой функции приведен на рис. 1.2.

Из графика видно, что наибольшее количество информации содержится в наименее вероятном сообщении.

Энтропия источника сообщений

Мера Ii характеризует количество информации только в данном сообщении ai. Она не дает общего представления об источнике информации.

Общее представление может дать среднее количество информации Н, выдаваемое источником в виде какого-либо из возможных сообщений ai. Это среднее количество информации характеризует источник сообщений в целом. Оно определяется как среднее значение (или математическое ожидание) количества информации, содержащегося в случайно выбранном сообщении ai.

По определению МОЖ величины Ii будем иметь:

(1.11)

(1.11)

Величина Н, определяемая выражением (1.11), называется энтропией источника сообщений.

Энтропией (или удельной информативностью) называется усредненное количество информации, приходящееся на одно сообщение рассматриваемого источника.

Энтропия является мерой неопределенности в передаче сообщений от источника: чем больше энтропия, тем больше информации несет в себе сообщение источника и тем большая неопределенность снимается при получении сообщения.

Количество информации и энтропия являются логарифмическими мерами и измеряются в одних и тех же единицах. Основание логарифма определяет единицу измерения количества информации и энтропии. Двоичная единица соответствует основанию логарифма, равному двум, и называется битом. 1 бит — это количество информации в сообщении об одном из двух равновероятных исходов некоторого события. Используются также натуральные и десятичные логарифмы. В этих случаях количество информации выражается в натуральных и десятичных единицах соответственно. Аналогичными единицами пользуются при оценке количества информации с помощью аддитивной меры Хартли (1.5).

Некоторые свойства энтропии

Из выражения (1.11) следует, что количество информации, содержащейся в сообщении, зависит от числа элементов сообщения n, используемого алфавита т и вероятностей выбора сообщений рi. Рассмотрим зависимость количества информации и энтропии от этих величин. Нетрудно видеть, что зависимость I от п является линейной. Величины т и р влияют на количество информации и энтропию примерно одинаково, поэтому ограничимся рассмотрением основных свойств энтропии.

1.  Энтропия является величиной вещественной ограниченной и неотрицательной, т. е. H>0. Это свойство следует из выражения (1.11) с учетом того, что величины р являются неотрицательными величинами и заключены в промежутке 0 < pi < 1. Все слагаемые, входящие в сумму (1.11), являются также величинами неотрицательными и изменяются при изменении рi от нуля до единицы. Используя правила нахождения пределов и максимума функции, можно убедиться, что при pi = 0 и pi= 1 слагаемое -рi log pi равняется нулю и достигает максимального значения, равного 0, 531 при

Энтропия является величиной вещественной ограниченной и неотрицательной, т. е. H>0. Это свойство следует из выражения (1.11) с учетом того, что величины р являются неотрицательными величинами и заключены в промежутке 0 < pi < 1. Все слагаемые, входящие в сумму (1.11), являются также величинами неотрицательными и изменяются при изменении рi от нуля до единицы. Используя правила нахождения пределов и максимума функции, можно убедиться, что при pi = 0 и pi= 1 слагаемое -рi log pi равняется нулю и достигает максимального значения, равного 0, 531 при  . График зависимости величины одного слагаемого от рi приведен на рис. 1.3. Поскольку все слагаемые суммы вещественны, неотрицательны и конечны, то при любом конечном т энтропия также будет вещественной, неотрицательной и конечной величиной.

. График зависимости величины одного слагаемого от рi приведен на рис. 1.3. Поскольку все слагаемые суммы вещественны, неотрицательны и конечны, то при любом конечном т энтропия также будет вещественной, неотрицательной и конечной величиной.

2. Энтропия минимальна и равна нулю, если сообщение известно заранее, т. е. если рi = 1, а р1 = р2 = … = рi-1 = рi+1 =...=pL=0.

3. Энтропия максимальна, если все состояния элементов сообщений равновероятны. Данное свойство энтропии легко доказывается с помощью методов вариационного исчисления. Мы воспользуемся конечным результатом, согласно которому Н = Нmaх, если

p1 = p2 = … = pL = p =  . (1.12)

. (1.12)

Величину максимальной энтропии найдем при использовании (1.11) и (1.12)

Hmax= (1.13)

(1.13)

4. Энтропия бинарных сообщений может изменяться от нуля до единицы.

Вам также может быть полезна лекция "Глава 1. Понятие - форма".

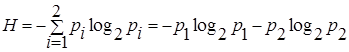

Бинарные сообщения характеризуются использованием двоичного алфавита, т. е. L = 21 = 2. Для таких сообщений

(1.14)

(1.14)

Используя условие  = 1 для данного случая и обозначив р1 = р, получим р2=1-p1=q, а энтропия H определится выражением

= 1 для данного случая и обозначив р1 = р, получим р2=1-p1=q, а энтропия H определится выражением

H = - p log2p – q log2 q (1.15)

Зависимость энтропии бинарных сообщений от вероятности выбора одного из элементов приведена на рис. 1.4. Энтропия достигает максимума, равного единице, при р1 = р2 = 0, 5.

|