Основные задачи теории информации

ГЛАВА 9. Основные задачи теории информации

Теория информации - область, в которой изучаются основные количественные закономерности, связанные с получением, хранением, передачей и обработкой информации.

Теория информации позволяет сравнивать различные системы связи. Решение указанных задач стало возможным лишь с введением в ней таких понятий как энтропия и количество информации, которые позволили получить количественное описание процессов передачи информации и установить их общие закономерности.

Особенностью теории информации является то, что она изучает предельные возможности статистического и помехоустойчивого кодирования, которые понимаются в том смысле, что допускается любая, в пределе бесконечно большая, продолжительность операций кодирования и декодирования, а также любая сложность кодеров и декодеров.

9.1. Количество информации в дискретных сообщениях. Энтропия источника дискретных сообщений.

Для сравнения различных систем связи необходимо ввести некоторую количественную меру, позволяющую оценивать объем информации, содержащейся в сообщении, и объем передаваемой информации.

Рассмотрим сначала основные положения теории информации для дискретных систем связи. Обозначим возможные различные символы на входе некоторого блока СПИ через αi, i = 1,…, m, а выходные символы через yj, j = 1,…,n. Под символом αi можно подразумевать символы источника, информационные последовательности, сигналы на входе линии связи, а под символами yj - символы закодированных сообщений, кодовые последовательности, сигналы на выходе линии связи.

Рассмотрим простейший случай, когда αi, i = 1,…, m, взаимно независимые. При этом источник А полностью описывается априорными вероятностями  которые и характеризуют первоначальное незнание (первоначальную неопределенность) о появлении конкретного символа αi на входе блока.

которые и характеризуют первоначальное незнание (первоначальную неопределенность) о появлении конкретного символа αi на входе блока.

При наличии помех между символами αi и yj нет однозначного соответствия, т.е. символ αi может перейти в любой символ yj с некоторой условной вероятностью которую можно вычислить, если известен механизм такого перехода. Зная вероятности

которую можно вычислить, если известен механизм такого перехода. Зная вероятности  и

и  нетрудно найти вероятности

нетрудно найти вероятности  появления на входе блока символов αi, i = 1,…, m, при условии, что на выходе блока наблюдался символ yj. Эти вероятности, называемые апостериорными, характеризуют оставшееся незнание (оставшуюся неопределенность) о появлении на входе символов αi, i = 1,…, m, при наблюдении символа yj на выходе блока.

появления на входе блока символов αi, i = 1,…, m, при условии, что на выходе блока наблюдался символ yj. Эти вероятности, называемые апостериорными, характеризуют оставшееся незнание (оставшуюся неопределенность) о появлении на входе символов αi, i = 1,…, m, при наблюдении символа yj на выходе блока.

Рекомендуемые материалы

Таким образом, полученная информация о символе αi при наблюдении символа yj приводит к изменению вероятности появления символа αi от ее априорного значения  к ее апостериорному значению

к ее апостериорному значению  . При этом представляется обоснованным взять за количество информации о символе αi, содержащейся в символе yj, некоторую функцию только вероятностей

. При этом представляется обоснованным взять за количество информации о символе αi, содержащейся в символе yj, некоторую функцию только вероятностей  и

и  :

:

(9.1)

(9.1)

Такое определение количества информации, несвязанное с физической природой сообщения, позволяет строить довольно общую теорию, в частности, сравнивать различные системы связи по эффективности.

В качестве функции  удобно использовать логарифм отношения апостериорной

удобно использовать логарифм отношения апостериорной  вероятности к априорной

вероятности к априорной  , т.е. определить

, т.е. определить  как

как

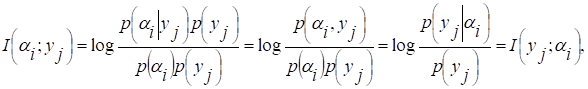

(9.2)

(9.2)

При таком задании, в частности, количество информации обладает свойством аддитивности: количество информации о символе αi(в дальнейшем для общности рассуждения - событии αi), доставляемой двумя независимыми символами (событиями) yj и zk:

(9.3)

(9.3)

Это свойство хорошо согласуется с "интуитивным" понятием информации.

Основание логарифма может быть любым. От него зависит единица измерения количества информации. В технических приложениях обычно используют основание 2. При этом количество информации I измеряется в двоичных единицах или битах. При проведении математических выкладок зачастую удобно пользоваться натуральными логарифмами. Соответственно информация измеряется в натуральных единицах или натах.

Введенная величина  обладает важным свойством симметрии по отношению к αi и yj:

обладает важным свойством симметрии по отношению к αi и yj:

(9.4)

т.е. информация, доставляемая событием yj о событии αi равна информации, доставляемой событием αi о событии yj. По этой причине  называется взаимной информацией двух случайных событий относительно друг друга.

называется взаимной информацией двух случайных событий относительно друг друга.

Из (9.4) следует, что если события αi и yj статистически независимы, то  , т.е. независимые события не несут друг о друге никакой информации.

, т.е. независимые события не несут друг о друге никакой информации.

Взаимная информация при фиксированной вероятности принимает максимальное значение, когда апостериорная вероятность  , т.е. когда наблюдаемое событие yj однозначно определяет событие αi. При этом

, т.е. когда наблюдаемое событие yj однозначно определяет событие αi. При этом

(9.5)

(9.5)

Величина  называется собственной информацией события αi. Ее можно интерпретировать как количество информации, которое доставляет событие αi или любое другое, однозначно связанное с ним. Собственная информация всегда является неотрицательной величиной, причем чем менее вероятно событие, тем она больше. Взаимная информация может быть как положительной, так и отрицательной величиной.

называется собственной информацией события αi. Ее можно интерпретировать как количество информации, которое доставляет событие αi или любое другое, однозначно связанное с ним. Собственная информация всегда является неотрицательной величиной, причем чем менее вероятно событие, тем она больше. Взаимная информация может быть как положительной, так и отрицательной величиной.

Пусть αi, yj, zk - статистически зависимых события. Предположим, что событие zk известно. Количество информации о событии αi, доставляемое событием yj при условии, что zk известно, называется условной взаимной информацией. Она определяется так же, как и взаимная информация, однако априорная и апостериорная вероятности должны быть взяты при условии zk, т.е.

(9.6)

(9.6)

Отсюда следует, что условная взаимная информация при фиксированной вероятности  принимает максимальное значение, когда

принимает максимальное значение, когда  . При этом

. При этом

(9.7)

(9.7)

Величина  называется условной собственной информацией. Ее можно интерпретировать как количество информации, доставляемое событием αi при известном событии zk, или как количество информации, которое должно доставляться некоторым другим событием для однозначного определения события при известном zk.

называется условной собственной информацией. Ее можно интерпретировать как количество информации, доставляемое событием αi при известном событии zk, или как количество информации, которое должно доставляться некоторым другим событием для однозначного определения события при известном zk.

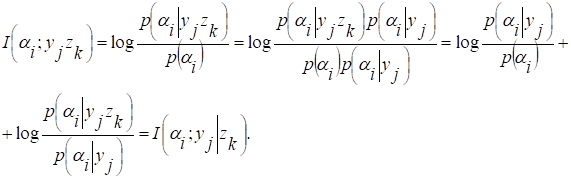

Покажем, что взаимная информация удовлетворяет свойству аддитивности. Пусть αi, yj и zk - три статистически зависимых события. Тогда количество информации о событии αi, которое доставляют события yj и zk

(9.8)

Таким образом, количество информации о событии αi, которое доставляют события yj и zk, равно сумме информации, доставляемой zk при известном событии yj.

Аналогично можно показать, что

(9.9)

(9.9)

Используя соотношения (9.2), (9.4), (9.5) и (9.7), можно взаимную информацию записать в одной из следующих форм:

(9.10)

(9.10)

(9.11)

(9.11)

(9.12)

(9.12)

где  - собственная информация сложного события αiyj.

- собственная информация сложного события αiyj.

Соотношение (9.10) можно интерпретировать следующим образом. Взаимная информация  равна разности между количеством информации, требуемой для определения αi до и после того, как становится известным yj. Нетрудно пояснить и соотношения (9.11) и (9.12), а количество информации о множестве А передаваемых символов, которое в среднем содержится в множестве Y принимаемых символов.

равна разности между количеством информации, требуемой для определения αi до и после того, как становится известным yj. Нетрудно пояснить и соотношения (9.11) и (9.12), а количество информации о множестве А передаваемых символов, которое в среднем содержится в множестве Y принимаемых символов.

. (9.13)

. (9.13)

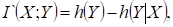

Величина I(A;Y) называется средней взаимной информацией.

Нетрудно показать, что

(9.14)

(9.14)

На практике также вызывает интерес не собственная информация, а средняя собственная информация.

(9.15)

(9.15)

Она характеризует количество информации, которое в среднем необходимо для определения любого символа из множества А возможных передаваемых символов.

Выражение (9.15) идентично выражению для энтропии системы в статистической механике. Поэтому величину I(A) называют энтропией дискретного источника А и обозначают через Н(А). Чем больше Н(А), тем более неопределенным является ожидаемый символ. Поэтому энтропию можно рассматривать как меру неопределенности символа до того, как он был принят.

Из (9.15) следует, что Н(А)≥0, т.е. энтропия является неотрицательной величиной. Она обращается в нуль, когда одна из вероятностей р(αi) равна единице, а остальные нулю. Этот результат хорошо согласуется с физическим смыслом. Действительно, такая ситуация возникает, например, когда передается только один символ. Поскольку он заранее известен, то неопределенность источника равна нулю и с появлением символа мы не получаем никакой информации.

Энтропия удовлетворяет неравенству

(9.16)

(9.16)

причем знак неравенства имеет место, когда  где m - число возможных событий αi (число различных символов, сообщений и т.п.). Это свойство можно доказать, используя неравенство

где m - число возможных событий αi (число различных символов, сообщений и т.п.). Это свойство можно доказать, используя неравенство

(9.17)

(9.17)

Рассмотрим разность

(9.18)

(9.18)

Учитывая (9.17), находим

(9.19)

(9.19)

Знак равенства имеет место, когда  так как только при

так как только при  неравенство (9.17) превращается в равенство. При этом энтропия принимает максимальное значение

неравенство (9.17) превращается в равенство. При этом энтропия принимает максимальное значение  .

.

Из (9.16) вытекает следующий важный вывод: при заданном алфавите символов количество информации, которое в среднем может содержаться в одном символе, достигает максимума, когда все символы используются с равной вероятностью. При этом величину  называют информационной емкостью алфавита.

называют информационной емкостью алфавита.

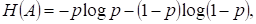

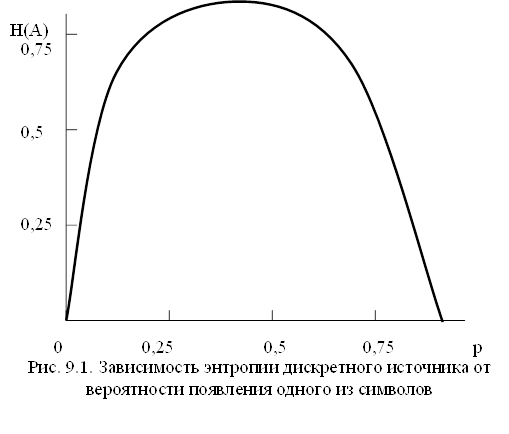

Для алфавита, состоящего из двух символов,

где р - вероятность появления одного из символов. При р = 1/2 (рис.9.1.) энтропия принимает максимальное значение  дв.ед. Таким образом, двоичная единица информации, или бит, - количество информации, которое содержится в одном двоичном символе, появляющемся с вероятностью р=0,5.

дв.ед. Таким образом, двоичная единица информации, или бит, - количество информации, которое содержится в одном двоичном символе, появляющемся с вероятностью р=0,5.

Подобно тому, как было введено понятие средней собственной информации, можно ввести понятие условной собственной информации:

(9.20)

(9.20)

Величина  характеризует количество информации, которое в среднем необходимо для определения любого символа из алфавита А при известном множестве событий Z, т.е. характеризует неопределенность символа алфавита А до того, как он был принят, при условии, что множество событий Z известно. Она называется условной энтропией и обозначается через

характеризует количество информации, которое в среднем необходимо для определения любого символа из алфавита А при известном множестве событий Z, т.е. характеризует неопределенность символа алфавита А до того, как он был принят, при условии, что множество событий Z известно. Она называется условной энтропией и обозначается через  .

.

Используя неравенство (9.17), нетрудно показать, что

(9.21)

(9.21)

причем знак равенства имеет место, когда события αi и zk статистически независимы ( для всех индексов i и k).

для всех индексов i и k).

Соотношение (9.21) играет важную роль в теории кодирования. На его основе можно сделать следующий вывод: для того, чтобы каждый символ кодовой комбинации доставлял как можно больше информации, необходимо обеспечивать статистическую независимость каждого символа кодовой комбинации от предыдущих символов.

Можно ввести понятие энтропии множества совместных событий A и Z:

(9.22)

(9.22)

Подставляя вместо вероятности  под знаком логарифма произведение

под знаком логарифма произведение  , выражение (9.22) можно привести к виду

, выражение (9.22) можно привести к виду

(9.23)

(9.23)

Если события αi и zk статистически независимы, то формулу (9.23) можно переписать в виде

(9.24)

(9.24)

Соотношения (9.23) и (9.24) есть не что иное, как свойство аддитивности энтропии.

Среднюю взаимную информацию можно представить как

(9.25)

(9.25)

(9.26)

(9.26)

(9.27)

(9.27)

Выражение (9.25) имеет простую физическую интерпретацию, когда αi- переданный символ, а yj - принятый. При этом Н(А) можно рассматривать как среднее количество передаваемой информации, H(A│Y) - как среднее количество информации, теряемой в канале связи (величину H(A│Y) обычно называют надежностью), I(A;Y) - как среднее количество информации, получаемой с приходом каждого символа. Нетрудно дать соответствующие интерпретации соотношениям (9.26) и (9.27).

Энтропия H(Y│A) определяется только помехой в канале связи и называется шумовой.

Пусть TC - среднее время передачи одного символа. Тогда величина R=I′(А;Y)=(1/ TC ) I(A;Y) характеризует среднее количество информации, передаваемое в единицу времени. Ее называют скоростью передачи информации.

Величина H`(A)=(1/Tc)H(A) характеризует среднее количество информации, выдаваемое источником. Ее называют производительностью источника.

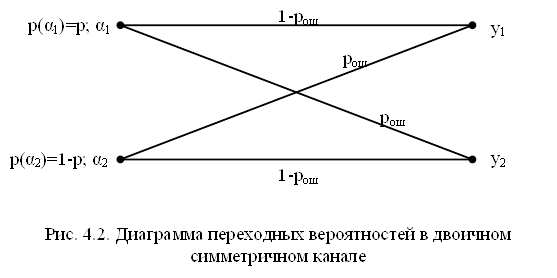

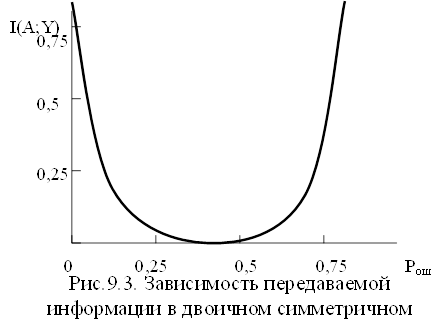

Найдем среднее количество информации, передаваемое по двоичному симметричному каналу (рис.9.2)

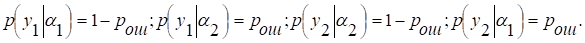

Пусть на вход канала поступают двоичные символы α1 и α2 с вероятностями р и (1-р) соответственно. На выходе канала появляются двоичные символы y1 и y2. Вероятность ошибки при передаче любого символа равна рош. Таким образом,

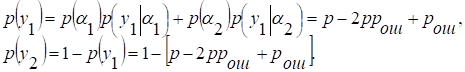

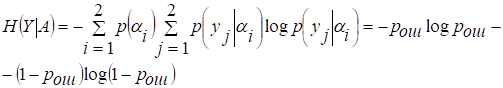

Воспользуемся формулой (9.26). Энтропия

.

.

С учетом рассматриваемой модели канала

Нетрудно убедиться, что H(Y) принимает максимальное значение, равное 1, при р = 1/2.

Условная энтропия

Заметим, что для рассматриваемого случая H(Y│A) не зависит от вероятности р.

Подставляя выражения для H(Y) и H(Y│A) в (4.21), находим I(A;Y). В частности, при р = 1/2

(9.28)

(9.28)

Таким образом, среднее количество информации, передаваемое каждым символом по двоичному симметричному каналу, при р = 1/2 зависит только от вероятности ошибочного приема символа (рис. 9.3)

В отсутствие помех (рош=0) I(A;Y)=1 дв.ед., при рош=1/2 I(A;Y)=0, т.е. никакой информации не передается; при рош=1 I(A;Y)=1 дв.ед. В последнем случае, хотя все принятые символы ошибочные, однако передаваемые сообщения можно легко восстановить, поставив в соответствие сигналу y1 символ α2, а сигналу y2 символ α1.

9.2. Избыточность сообщений

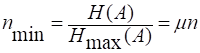

Рассмотрим ансамбль A, состоящий из m различных символов  . Энтропия такого дискретного источника достигает максимального значения

. Энтропия такого дискретного источника достигает максимального значения  , когда символы статистически независимы и появляются на его выходе с одинаковой вероятностью, равной 1/ m. На практике часто символы неравновероятны и зависимы. Поэтому энтропия источника

, когда символы статистически независимы и появляются на его выходе с одинаковой вероятностью, равной 1/ m. На практике часто символы неравновероятны и зависимы. Поэтому энтропия источника  . Соответственно количество информации, доставляемое такими символами, меньше возможного в

. Соответственно количество информации, доставляемое такими символами, меньше возможного в  раз.

раз.

Пусть сообщение состоит из n символов. Очевидно, что количество информации в нем  . При использовании алфавита с максимальной энтропией для передачи такого же объема информации потребовалось бы число символов. Очевидно, что количество информации в нем I=nH(A). При использовании алфавита с максимальной энтропией для передачи такого же объема информации потребовалось бы число символов

. При использовании алфавита с максимальной энтропией для передачи такого же объема информации потребовалось бы число символов. Очевидно, что количество информации в нем I=nH(A). При использовании алфавита с максимальной энтропией для передачи такого же объема информации потребовалось бы число символов

где,  - коэффициент, характеризующий допустимую степень сжатия сообщений.

- коэффициент, характеризующий допустимую степень сжатия сообщений.

Величина  называется избыточностью источника.

называется избыточностью источника.

9.3. Пропускная способность дискретных каналов с шумом

Среднее количество информации, передаваемое по дискретному каналу в расчете на один символ, определяется как

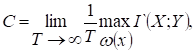

где А и Y -множества символов на входе и выходе канала. Энтропия Н(А) определяется только источником входных символов. Энтропии H(A│Y), H(A) и H(Y│A) в общем случае зависят как от источника входных символов, так и от свойств канала. Поэтому скорость передачи информации зависит не только от канала, но и от источника сообщений. Максимальное количество переданной информации в единицу времени, взятое по всевозможным источникам входных символов (по всем многомерным распределениям вероятности Р(А), характеризующим эти источники),

(9.29)

(9.29)

называется пропускной способностью канала.

Пропускную способность канала можно определить и в расчете на символ:

(9.30)

(9.30)

9.4. Пропускная способность непрерывных каналов с

аддитивным шумом

Пусть сигнал y(t) на выходе канала представляет собой сумму полезного сигнала x(t) и шума n(t), т.е.

y(t) = x(t) + n(t), 0≤t≤T, (9.31)

причем сигнал x(t) и шум n(t) статистически независимы. Допустим, что канал имеет ограниченную полосу пропускания шириной Fк. Тогда в соответствии с теоремой Котельникова функции y(t) , x(t) и n(t) можно представить совокупностями отсчетов yi, xi и ni, i=1,…,M, где М = 2FкТ. При этом статистические свойства сигнала x(t) можно описать многомерной плотностью вероятности  а статистические свойства шума - плотностью вероятности

а статистические свойства шума - плотностью вероятности  где x и n - векторы с координатами

где x и n - векторы с координатами  и

и  соответственно.

соответственно.

Пропускная способность непрерывного канала

где  - количество информации о какой-либо реализации сигнала x(t) длительности Т, которое в среднем содержит реализация сигнала y(t) той же длительности Т, максимум ищется по всем возможным распределениям ω(x).

- количество информации о какой-либо реализации сигнала x(t) длительности Т, которое в среднем содержит реализация сигнала y(t) той же длительности Т, максимум ищется по всем возможным распределениям ω(x).

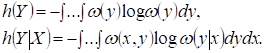

Среднюю взаимную информацию можно определить как

где

Заметим, что с учетом (9.31) условная плотность вероятности  и

и

Таким образом, пропускная способность непрерывного канала с аддитивным шумом

(9.32)

(9.32)

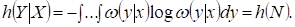

Вычислим пропускную способность непрерывного канала без памяти с аддитивным белым гауссовским шумом, имеющим одностороннюю спектральную плотность N0, для случая, когда средняя мощность полезного сигнала равна Pc. При этом отсчеты шума оказываются статистически независимыми и дифференциальная энтропия

(9.33)

(9.33)

где  - дисперсия шума n(t).

- дисперсия шума n(t).

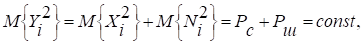

Определим максимально возможное значение дифференциальной энтропии h(Y). Прежде всего отметим, что

т.е. средний квадрат отсчета Yi фиксирован. При этом дифференциальная энтропия h(Yi) принимает максимальное значение, когда случайная величина Yi является гауссовской с нулевым математическим ожиданием. Это имеет место, если случайная величина Xi гауссовская с нулевым математическим ожиданием.

Дифференциальная энтропия h(Y) совокупности из n отсчетов будет максимальна, если отсчеты будут статистически независимы. Это имеет место, если спектральная плотность мощности процесса X(t) равномерна в полосе частот Fk.

При выполнении указанных требований к сигналу

(9.34)

(9.34)

Подставляя (9.33) и (9.34) в (9.32), находим

(9.35)

(9.35)

Формулу (9.35) часто называют формулой Шеннона. Подчеркнем, что она справедлива для следующей идеализированной модели канала связи. Выходное колебание y(t) представляет собой сумму входного сигнала x(t) и шума n(t), причем сигнал и шум являются статистически независимыми гауссовскими случайными процессами с нулевыми математическими ожиданиями и имеют равномерные спектральные плотности мощности в полосе частот  .

.

Формула (9.35) очень важна для системы связи, так как она устанавливает связь между пропускной способностью непрерывного канала с ограниченной полосой частот и техническими характеристиками системы: шириной полосы пропускания канала и отношением сигнал/шум. Из нее следует, что одну и ту же пропускную способность можно получить при различных соотношениях Fk и Pc/Pш. Другими словами, формула (9.35) указывает на возможность обмена полосы пропускания на мощность сигнала и наоборот. С учетом зависимостей С от Fk и С от Pc/Pш очевидна целесообразность обмена мощности сигнала на полосу.

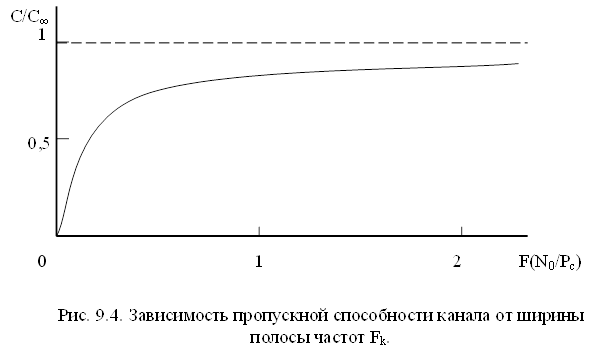

Из (9.35) нетрудно видеть, что пропускная способность канала растет с увеличением полосы частот Fk (рис.9.4.) и при  стремится к предельному значению

стремится к предельному значению

Вам также может быть полезна лекция "21 Система премирования работников".

Заметим, что пропускная способность непрерывного канала, в котором действует шум, отличный от белого гауссовского, больше, чем дает формула (9.35)

9.5. Теорема кодирования для канала с помехами

Пропускная способность дискретного и непрерывного каналов характеризуют их предельные возможности как средств передачи информации. Они раскрываются в фундаментальной теореме теории информации, которая известна как основная теорема кодирования К.Шеннона. Применительно к дискретному источнику она гласит: если производительность источника сообщений H`(A) меньше пропускной способности канала С, то существует по крайней мере одна процедура кодирования и декодирования, и ненадежность H(A│Y) могут быть сколь угодно малы. Если H`(A)>C, то такой процедуры не существует.

Результат основной теоремы кодирования для канала с шумом в определенной степени неожидан. В самом деле, на первый взгляд кажется, что уменьшение вероятности ошибок в передаче сообщений требует соответствующего уменьшения скорости передачи и, что последняя должна стремиться к нулю вместе с вероятностью ошибок. Такой вывод, в частности, вытекает из рассмотрения многократной повторной передачи символов источника по каналу как способа уменьшения вероятности ошибок в передаче сообщений. В этом случае при наличии помех в канале связи обеспечить стремление к нулю вероятности ошибки в передаче сообщения можно только при стремлении скорости передачи к нулю.

Однако теорема кодирования показывает, что в принципе можно вести передачу со скоростью, сколь угодно близкой к С, достигая при этом сколь угодно малой вероятности ошибки. К сожалению, теорема, указывая на принципиальное существование помехоустойчивого кода, не дает рецепта его нахождения. Можно лишь отметить, что для этого необходимо применять коды большой длины. При этом по мере приближения скорости передачи к пропускной способности и уменьшения вероятности ошибки код усложняется вследствие увеличения длины блоков, что приводит к резкому усложнению кодирующего и декодирующего устройств и запаздыванию при декодировании. Применяемые в настоящее время способы кодирования не реализуют потенциальных возможностей систем связи. О степени совершенства системы связи можно судить по отношению  .

.

Для канала с пропускной способностью С, на входе которого включен источник непрерывных сообщений, К.Шеннон доказал следующую теорему: если при заданном критерии эквивалентности сообщений источника  его эпсилон-энтропия

его эпсилон-энтропия  меньше пропускной способности канала С, то существует способ кодирования и декодирования, при котором погрешность воспроизведения сколь угодно близка к

меньше пропускной способности канала С, то существует способ кодирования и декодирования, при котором погрешность воспроизведения сколь угодно близка к  . При

. При  такого способа не существует.

такого способа не существует.